行业新闻与博客

针对机器学习系统的对抗攻击-您需要了解的一切

2019年3月,腾讯的安全研究人员设法欺骗了特斯拉 Model S 进入交换车道。

他们要做的就是在路上贴上一些不起眼的贴纸。该技术利用了机器学习(ML)算法中的故障,该故障为 Tesla 的车道检测技术提供了强大的动力,从而使其行为不稳定。

机器学习已经成为我们每天使用的许多应用程序的组成部分-从 iPhone 上的面部识别锁到 Alexa 的语音识别功能以及电子邮件中的垃圾邮件过滤器。

但是,机器学习及其深度学习的普遍性也引起了对抗性攻击,这是一种通过向算法提供精心设计的输入数据来操纵算法行为的攻击。

什么是对抗攻击?

“研究攻击是旨在破坏机器学习性能,导致模型行为不当或获取受保护信息的操纵性行为,” IBM Research 的 RPI-IBM AI 研究合作首席科学家 Chen Pin-Yu Chen 告诉 The Daily Swig。

对抗机器学习最早于 2004年进行了研究。但是在当时,它被认为是一种有趣的特性,而不是安全威胁。但是,近年来,深度学习的兴起及其在许多应用程序中的集成,引起了人们对对抗性机器学习的兴趣。

安全社区越来越担心,可以利用对抗性漏洞来攻击 AI 驱动的系统。

对抗攻击如何工作?

与开发人员手动编写指令和规则的经典软件相反,机器学习算法通过经验来发展其行为。

例如,为了创建车道检测系统,开发人员创建了机器学习算法,并通过向其提供来自不同角度和在不同光照条件下的许多带标签的街道车道图像来对其进行训练。

然后,机器学习模型会调整其参数以捕获包含街道车道的图像中出现的常见模式。

借助正确的算法结构和足够的训练示例,该模型将能够以极高的准确性检测新图像和视频中的车道。

尽管机器学习算法在计算机视觉和语音识别等复杂领域取得了成功,但它们还是统计推理引擎:将输入转换为输出的复杂数学函数。

如果机器学习将图像标记为包含特定对象,则它会发现该图像中的像素值在统计上与其在训练过程中处理过的对象的其他图像相似。

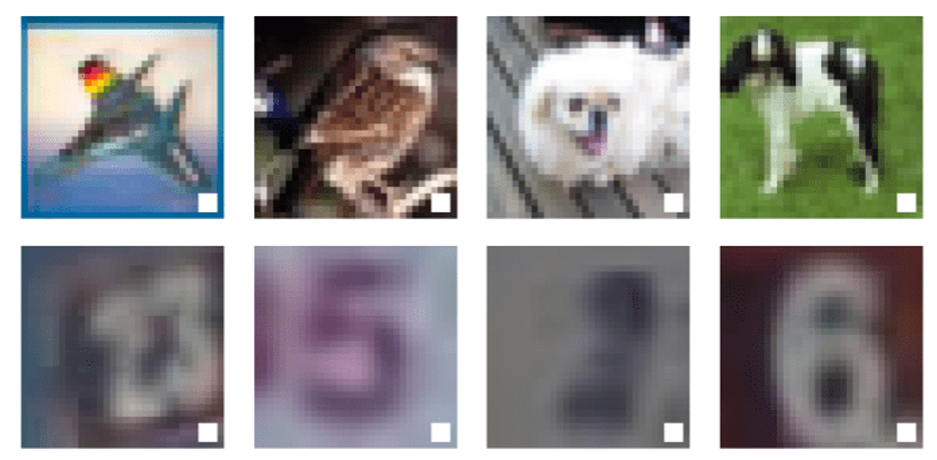

对抗攻击利用此特征通过操纵其输入数据来混淆机器学习算法。例如,通过在图像上添加微小且不起眼的像素斑块,恶意参与者可以使机器学习算法将其分类为不是。

在对抗性攻击中应用的干扰类型取决于目标数据类型和所需效果。Chen 说:“需要针对不同的数据模式定制威胁模型,以使其具有合理的对抗性。”

“例如,对于图像和音频,将小数据扰动视为威胁模型是有道理的,因为它不会被人轻易感知,但可能会使目标模型行为不当,从而导致人机之间的不一致。

“但是,对于某些数据类型(例如文本),“扰动”通过简单地更改单词或字符,可能会破坏语义并容易被人类检测到。因此,文本的威胁模型应该自然不同于图像或音频。”

对计算机视觉系统的对抗攻击

对抗性机器学习研究最广泛的领域涉及处理视觉数据的算法。本文开头提到的变道技巧是视觉对抗攻击的一个示例。

在 2018年,一组研究人员表明 在停车标志 (PDF)上添加贴纸,他们可能会欺骗自动驾驶汽车的计算机视觉系统,将其误认为是限速标志。

在另一种情况下,卡内基梅隆大学的研究人员设法使面部识别系统误入使用名人的眼镜,以使其误以为是名人。

针对面部识别系统的对抗攻击已在抗议活动中首次真正使用,其中示威者使用贴纸和化妆来欺骗由机器学习算法提供支持的监控摄像头。

针对语音识别系统的对抗攻击

计算机视觉系统并不是对抗攻击的唯一目标。在 2018年,研究人员表明,自动语音识别(ASR)系统也可能成为对抗攻击的目标 (PDF)。ASR 是使 Amazon Alexa,Apple Siri 和 Microsoft Cortana 能够解析语音命令的技术。

在假设的对抗性攻击中,恶意行为者会仔细操纵音频文件(例如,发布在 YouTube 上的歌曲)以包含隐藏的语音命令。人类的听众不会注意到这种变化,但是对于机器学习算法而言,它会在声波中寻找模式,这显然是可听见的,并且可以付诸实践。例如,音频对抗攻击可用于秘密地向智能扬声器发送命令。

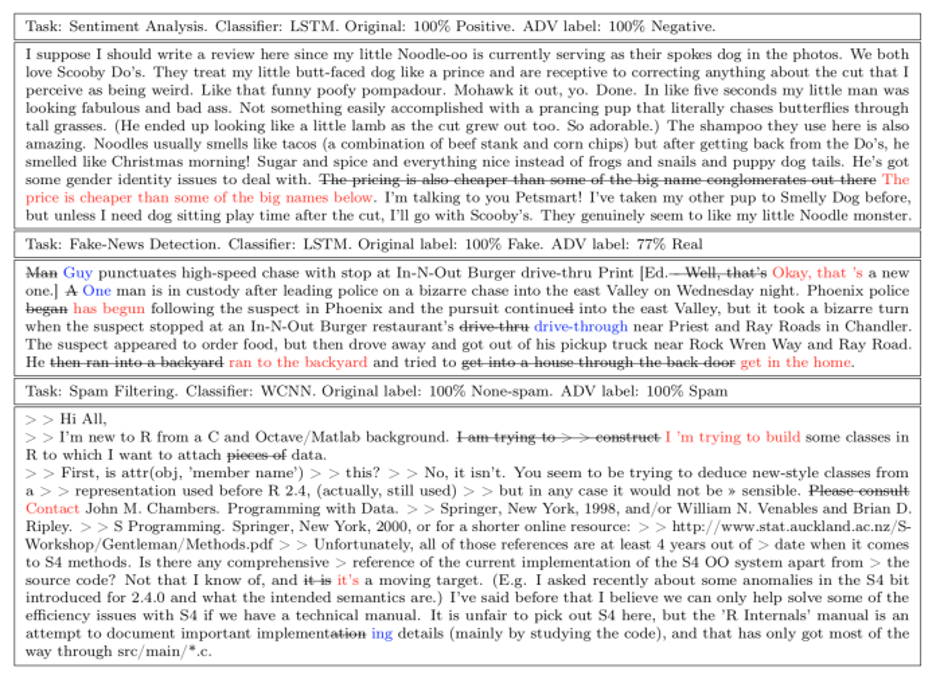

对抗文本分类器的攻击

在 2019年,Chen 及其同事在 IBM Research,亚马逊和德克萨斯大学的研究表明,对抗性示例也适用于文本分类器机器学习算法,例如垃圾邮件过滤器和情感检测器。

基于文本的对抗攻击被称为“释义攻击”,涉及对一段文本中的单词序列进行更改,从而导致机器学习算法中的错误分类错误。

黑盒与白盒对抗攻击

像任何网络攻击一样,对抗攻击的成功取决于攻击者在目标机器学习模型上拥有多少信息。在这方面,对抗性攻击分为黑盒攻击和白盒攻击。

Chen 说:“黑匣子攻击是实用的设置,攻击者只能通过有限的信息来访问目标 ML 模型。” 攻击者的能力与普通用户相同,并且只能在允许的功能下进行攻击。攻击者也不了解服务背后使用的模型和数据。”

阅读更多 AI 和机器学习安全新闻

例如,要针对诸如 Amazon Rekognition 之类的公共 API,攻击者必须通过反复向系统提供各种输入并评估其响应,直到发现对抗性漏洞,来探测系统。

Chen 说:“白盒攻击通常假设目标模型 / 数据具有完全的知识和完全的透明度。” 在这种情况下,攻击者可以检查模型的内部工作原理,并且可以更好地发现漏洞。

研究人员说:“从对手的角度评估部署的和访问受限的 ML 模型的鲁棒性时,黑匣子攻击更为实用,” “白盒攻击对于模型开发人员了解 ML 模型的局限性并提高模型训练期间的鲁棒性更为有用。”

数据中毒攻击

在某些情况下,攻击者可以访问用于训练目标机器学习模型的数据集。在这种情况下,攻击者可以执行“数据中毒”,在训练过程中有意向模型中注入对抗性漏洞。

例如,恶意行为者可能训练机器学习模型对特定像素模式秘密敏感,然后将其分发给开发人员以集成到他们的应用程序中。

考虑到开发机器学习算法的成本和复杂性,预训练模型的使用在 AI 社区中非常流行。分发模型后,攻击者使用对抗性漏洞攻击集成了该模型的应用程序。

“只有在存在触发模式时,被篡改的模型才会按照攻击者的意愿行事;否则,它将表现为正常模型。” Chen 说。他在最近的一篇论文中探讨了数据中毒攻击的威胁和补救措施。

这种对抗性攻击也称为后门攻击或特洛伊木马 AI,已经引起了情报高级研究计划(IARPA)的注意。

保护机器学习系统免受对抗性攻击

在过去的几年中,人工智能研究人员开发了各种技术,以使机器学习模型更强大地抵抗对抗攻击。最著名的防御方法是“对抗训练”,其中,开发人员通过在对抗示例中训练机器学习模型来修补漏洞。

其他防御技术包括更改或调整模型的结构,例如添加随机层并在多个机器学习模型之间外推,以防止利用任何单个模型的对抗性漏洞。

Chen 说:“我认为对抗攻击是在被认为是“成熟”的 ML 模型上进行“压力测试”和“调试”的聪明方法,”

“如果您认为一项技术在成为产品之前就应该经过充分的测试和调试,那么出于健壮性测试和改进的目的,对抗攻击将是 ML 技术开发流程中必不可少的一步。”

本文由机器译制

最近新闻

2023年02月16日

2021年11月25日

2021年10月11日

2021年09月07日

2021年08月03日

2020年12月01日

2020年12月01日

2020年12月01日